07.15

Mac(Apple Silicon)でAIが無償で使える時代が到来!LM Studioで始めるローカルAI革命

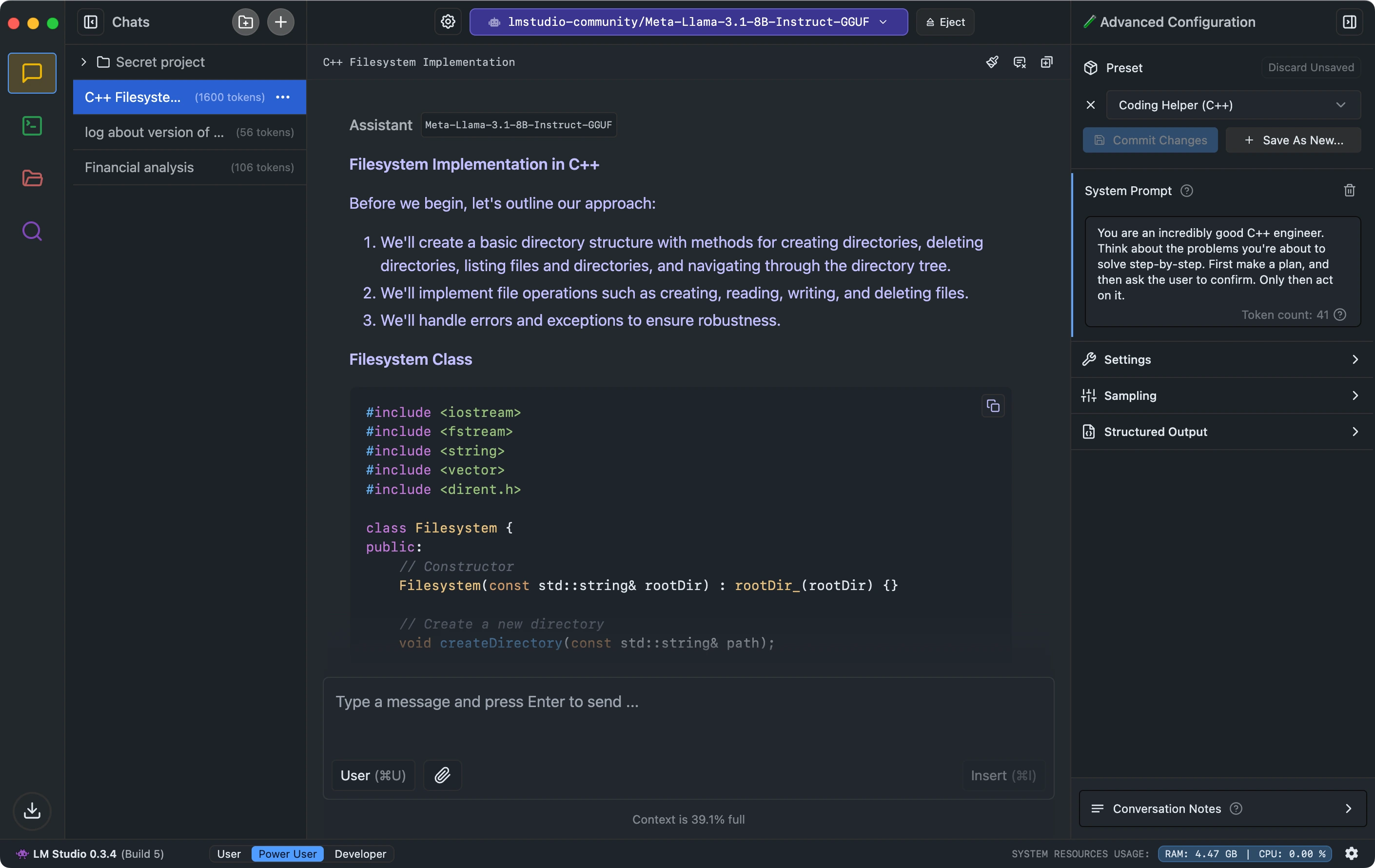

Apple Silicon搭載のMacユーザーにとって、これまで以上に魅力的な選択肢が登場しました。企業での使用も含めて完全無償化された「LM Studio」により、高性能なAIモデルを自分のコンピューター上で直接実行できるようになったのです。この記事では、LM Studioの基本的な使い方から実践的な活用方法まで、初心者にも分かりやすく解説します。

出典:LM Studio公式サイト(https://lmstudio.ai/)

LM Studioがゲームチェンジャーになった理由

2025年7月の歴史的転換点

「なぜ今、こんなに注目されているのか?」と思われるかもしれません。実は、2025年7月8日に発表された完全無償化が、LM Studioを一気に普及させる大きな転換点となったのです。

これまでLM Studioは個人利用では無料でしたが、企業や組織での使用には別途商用ライセンスが必要でした。しかし、Element Labs社の方針変更により、すべての利用形態で無料となったのです。この決定により、企業での導入障壁が大幅に下がり、プロフェッショナルな環境でも気軽に試せるようになりました。

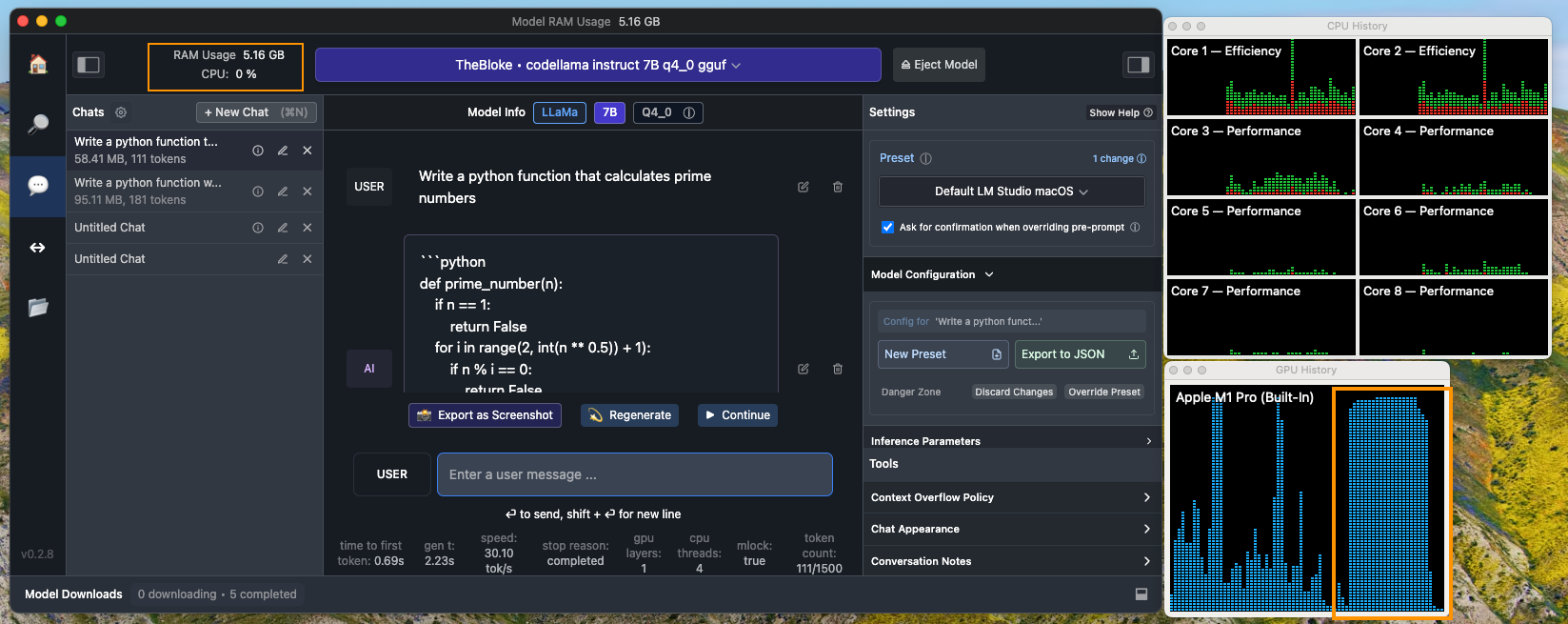

Apple Siliconの威力を最大限に活用

LM Studioの最大の魅力は、Apple Silicon(M1、M2、M3、M4チップ)の性能を最大限に引き出すことができる点にあります。これは、AppleのMLX(Machine Learning Exchange)フレームワークを活用しているからです。

MLXは、Apple独自の機械学習フレームワークで、Mac のUnified Memory、CPU、そしてGPUの力を統合的に活用します。つまり、一般的なWindowsマシンでは別々に管理されるCPUメモリとGPUメモリが、Macでは一つのメモリプールとして効率的に使用されるのです。

今すぐ始められる!LM Studioのインストール手順

必要なシステム要件

LM Studioを快適に動作させるには、以下の条件が必要です:

必須要件:

- macOS 13.4以降

- Apple Silicon搭載Mac(M1、M2、M3、M4)

- 最低16GB、推奨32GB以上のメモリ

推奨環境:

- 64GB以上のメモリ(大型モデル使用時)

- 十分なストレージ容量(モデルファイルが数GB〜数十GB)

ステップバイステップ・インストール手順

ステップ1:LM Studioのダウンロード

- LM Studio公式サイトにアクセス

- 「Download LM Studio for Mac」ボタンをクリック

- Apple Silicon用のmacOS版を選択してダウンロード

ステップ2:アプリケーションのインストール

- ダウンロードしたDMGファイルをダブルクリック

- LM Studioアプリをアプリケーションフォルダにドラッグ&ドロップ

- 初回起動時に「開く」を選択してセキュリティ確認を完了

ステップ3:初期設定

アプリケーションを起動すると、直感的なインターフェースが表示されます。初期設定では特に複雑な設定は不要で、すぐにモデルの検索とダウンロードを開始できます。

初心者におすすめのAIモデル選び

メモリ容量別おすすめモデル

LM Studioでは、様々なサイズのモデルを選択できます。あなたのMacのメモリ容量に応じて、最適なモデルを選びましょう。

16GB RAM環境

- Llama 3 ELYZA 8B: 日本語に特化した高性能モデル

- Gemma 3 9B: Googleが開発した効率的なモデル

- Qwen 2.5 7B: 中国Alibaba開発の多言語対応モデル

32GB RAM環境

- Llama 3 ELYZA 13B: より高精度な日本語応答が可能

- Code Llama 13B: プログラミング専用モデル

- Mixtral 8x7B: 複数の専門分野を持つモデル

64GB RAM環境

- Llama 3 70B: 最高レベルの性能を持つ大型モデル

- Qwen 2.5 32B: 高度な推論能力を持つモデル

- DeepSeek V3 32B: 最新の高性能モデル

日本語に特化したモデルの選び方

日本語での使用を主目的とする場合、以下のモデルが特におすすめです:

Llama 3 ELYZAシリーズは、株式会社ELYZAが開発した日本語特化型モデルで、自然な日本語での対話が可能です。特に、文脈の理解と適切な敬語使用において優れた性能を発揮します。

Swallowシリーズは、東京工業大学と産業技術総合研究所が共同開発した日本語モデルで、学術的な品質の高さが特徴です。

実践的な活用方法:あなたの仕事が変わる瞬間

チャット機能での基本的な使い方

LM Studioの最もシンプルな使い方は、チャット機能です。モデルを選択し、ロードした後、通常のチャットアプリケーションのように質問を入力するだけで、AIが応答を返してくれます。

「こんな基本的な機能で何ができるの?」と思われるかもしれませんが、実際に使ってみると、その可能性の広さに驚かされるでしょう。

ローカルAPIサーバーとしての活用

LM Studioの真価は、ローカルAPIサーバーとして動作させることで発揮されます。これにより、他のアプリケーションからAI機能を利用できるようになります。

設定手順:

- 「Local Server」タブを選択

- 使用したいモデルを選択

- 「Start Server」ボタンをクリック

- 「http://localhost:1234」でAPIサーバーが起動

この機能により、Web開発者は自分のアプリケーションにAI機能を統合したり、データ分析者はPythonスクリプトから直接AI機能を呼び出すことができます。

出典:Metric Coders(https://www.metriccoders.com/post/how-to-install-lm-studio-on-macos-a-quick-guide)

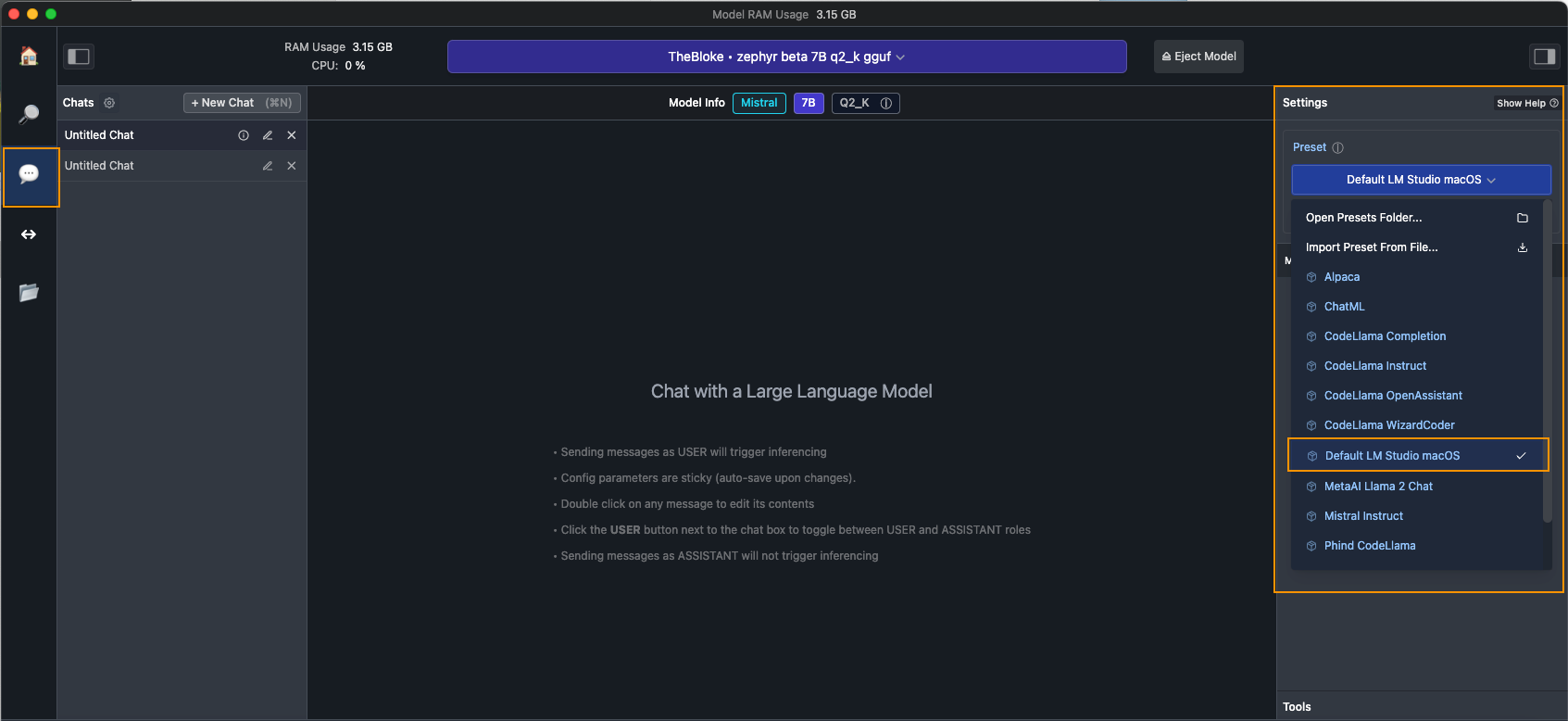

他のローカルAIツールとの比較

LM Studio vs Ollama:どちらを選ぶべき?

ローカルAI環境を構築する際、「LM Studio」と「Ollama」のどちらを選ぶべきか迷う方も多いでしょう。

LM Studioの特徴:

- 直感的なGUI(グラフィカルユーザーインターフェース)

- 初心者にも分かりやすい操作性

- モデルの検索、ダウンロード、管理が一元化

- Windows、Mac、Linux対応

Ollamaの特徴:

- コマンドライン中心の操作

- より軽量で高速

- 開発者向けの柔軟性

- オープンソースの透明性

結論として、「初心者や手軽に始めたい場合はLM Studio」、「コマンドラインに慣れ親しんでいる開発者はOllama」という選択が適しています。

性能面での比較

メモリ使用量の観点では、Ollamaの方が若干効率的とされていますが、LM StudioのGUIの利便性を考慮すると、多くのユーザーにとってはLM Studioの方が実用的です。

メモリ使用量とパフォーマンス最適化

メモリ要件の理解

ローカルAIの最大の制約は、メモリ容量です。一般的な目安として、以下のような関係があります:

- 7B(70億パラメータ)モデル: 約8-12GB

- 13B(130億パラメータ)モデル: 約16-20GB

- 32B(320億パラメータ)モデル: 約32-48GB

- 70B(700億パラメータ)モデル: 約70-100GB

Apple Silicon特有の最適化

Apple Siliconでは、Unified Memoryアーキテクチャにより、CPUとGPUがメモリを共有します。これにより、従来のPCよりも効率的にメモリを使用できます。

最適化のポイント:

- GPU Acceleration設定で「Use Apple Metal (GPU)」を有効化

- Context Lengthを適切に設定(通常は2048-4096)

- Batch Sizeを調整して応答速度を最適化

実際のユーザー体験:何ができるのか?

文書作成支援

LM Studioを使用することで、以下のような文書作成支援が可能になります:

- メール下書き: 丁寧な日本語でのビジネスメール作成

- 報告書作成: データを基にした分析レポートの下書き

- 企画書作成: アイデアの整理と構造化

プログラミング支援

Code Llamaのような専用モデルを使用することで、プログラミング作業を大幅に効率化できます:

- コードレビュー: 既存コードの改善提案

- バグ発見: 潜在的な問題の指摘

- 説明生成: 複雑なコードの動作説明

学習支援

教育分野での活用も期待できます:

- 要約作成: 長文の要点整理

- 質問応答: 学習内容の理解確認

- 翻訳支援: 外国語文献の理解

セキュリティとプライバシー:なぜローカルAIが重要なのか

データの完全なローカル処理

LM Studioの最大の利点の一つは、すべての処理がローカルで完結することです。これは、以下の点で重要な意味を持ちます:

プライバシー保護:

- 入力したデータはインターネットに送信されない

- 機密情報や個人情報の漏洩リスクがゼロ

- 企業の内部データを安全に処理可能

データ主権:

- 自分のデータを完全にコントロール

- 外部サービスの利用規約に縛られない

- 処理履歴の完全な管理

企業でのコンプライアンス対応

2025年7月の商用利用無料化により、企業でのコンプライアンス要件も満たしやすくなりました。金融機関や医療機関など、厳格なデータ管理が求められる業界でも、安心して導入できる環境が整いました。

トラブルシューティング:よくある問題と解決方法

モデルがうまく動作しない場合

症状:応答が遅い、または停止する

- 原因: メモリ不足、またはモデルサイズが大きすぎる

- 解決方法: より小さなモデルを選択、または量子化モデルを使用

症状:日本語の応答品質が悪い

- 原因: 英語中心のモデルを使用している

- 解決方法: 日本語特化モデル(ELYZA、Swallowなど)に変更

パフォーマンス関連の問題

症状:起動が遅い

- 原因: 大きなモデルファイルの読み込み

- 解決方法: SSDの使用、不要なモデルの削除

症状:メモリ使用量が多い

- 原因: 複数モデルの同時ロード

- 解決方法: 使用していないモデルのアンロード

2025年最新動向:LM Studioの未来

技術的進歩

2025年に入り、LM Studioは以下の面で大きな進歩を遂げています:

新機能の追加:

- マルチモーダル対応(テキスト+画像)

- より効率的な量子化技術

- プラグインシステムの拡張

性能向上:

- Apple Silicon最適化の継続的改善

- メモリ使用量の削減

- 応答速度の向上

AI業界への影響

LM Studioの無料化は、AI業界全体に大きな影響を与えています:

民主化の促進:

- 中小企業でのAI導入障壁の低下

- 個人開発者の創造性向上

- 教育機関でのAI教育普及

イノベーションの加速:

- ローカルAI技術の発展

- 新しいアプリケーションの創出

- オープンソースコミュニティの活性化

まとめ:あなたも今日からローカルAIを始めよう

LM Studioは、Apple Silicon搭載MacでローカルAIを体験する最も手軽で強力な方法です。2025年7月の完全無償化により、個人から企業まで、すべてのユーザーが制限なく利用できるようになりました。

LM Studioを今すぐ始めるべき理由:

- 完全無料で商用利用も可能

- Apple Siliconの性能を最大限活用

- プライバシーとセキュリティの完全な保護

- 豊富なモデル選択肢と日本語対応

最初は小さなモデルから始めて、徐々に大きなモデルに挑戦することをお勧めします。あなたの創造性と想像力が、ローカルAIの可能性を無限に広げてくれるでしょう。

今日から始められる第一歩:

- LM Studio公式サイトからダウンロード

- 推奨モデル(Llama 3 ELYZA 8B)をインストール

- 簡単な質問から始めて、AIとの対話を楽しむ

ローカルAI革命の波に乗り遅れないよう、今すぐLM Studioを試してみてください。あなたの仕事とクリエイティビティが、きっと新しい次元へと導かれるはずです。

参考文献

[1] LM Studio公式サイト「Discover, download, and run local LLMs」https://lmstudio.ai/

[2] ITmedia「ローカルLLM実行アプリ『LM Studio』業務利用を無料化」https://www.itmedia.co.jp/aiplus/articles/2507/10/news084.html

[3] PC Watch「MacでローカルLLMが動く!『LM Studio』で大規模言語モデルを試してみよう」https://pc.watch.impress.co.jp/docs/column/macinfo/2017274.html

[4] 技術評論社「ローカルLLM実行環境LM Studio、企業・組織での商用利用を無料に」https://gihyo.jp/article/2025/07/lm-studio-is-free-for-work

[5] forest watch「ローカルAIツール『LM Studio』が全面無償化」https://forest.watch.impress.co.jp/docs/news/2031038.html

[6] ChatGPT Lab「LM Studioの使い方 – ローカルLLMの導入からDify連携まで」https://chatgpt-lab.com/n/n1f74453cd24c

[7] Medium「Configure LM Studio for Apple Silicon」https://medium.com/@ingridwickstevens/configure-lm-studio-on-apple-silicon-with-87-7-faster-generations-b713cb4de6d4

[8] Zenn「Macで簡単にローカルLLMを試す(OllamaとLM Studio)」https://zenn.dev/nari007/articles/e7da01c5907854

[9] Peddals Blog「32GB RAM の Mac でローカル LLM をいい感じに動かす」https://blog.peddals.com/run-llm-on-32gb-ram-mac/

[10] mosuke tech「Mac mini M4 Pro (64GB) はローカルLLMの夢を見るか」https://blog.mosuke.tech/entry/2025/04/04/mac-mini-local-llm/

[11] Mac Fan Portal「ローカル生成AIを楽しむためのMacの選び方」https://macfan.book.mynavi.jp/article/53504/

[12] Qiita「DeepSeek R1を自宅のマシンでサクッと動かす方法」https://qiita.com/rsakao/items/6f1e05fa496d217234b6

[13] note「Mac miniでローカルLLM(LM Studio)動かしてみた」https://note.com/btm_hata/n/n6d2bc4db9175

[14] Zenn「Local LLMモデル入門:基礎知識編」https://zenn.dev/ignission/articles/366a9866215340

[15] Apple公式「Apple、Mac史上最もパワフルな新しいMac Studioを発表」https://www.apple.com/jp/newsroom/2025/03/apple-unveils-new-mac-studio-the-most-powerful-mac-ever/

タグ: LM Studio, Apple Silicon, Mac, ローカルAI, 無料AI, プライバシー, セキュリティ, 日本語AI, 機械学習, 自然言語処理

コメント

この記事へのトラックバックはありません。

この記事へのコメントはありません。